AI 浪潮推動資料中心耗電倍增

資料中心作為生成式 AI、高效能運算(HPC)與雲端服務的核心載體,推動 AI 伺服器的算力需求飆升,直接導致了單櫃功耗的指數級提升,資料中心的電力需求倍增。

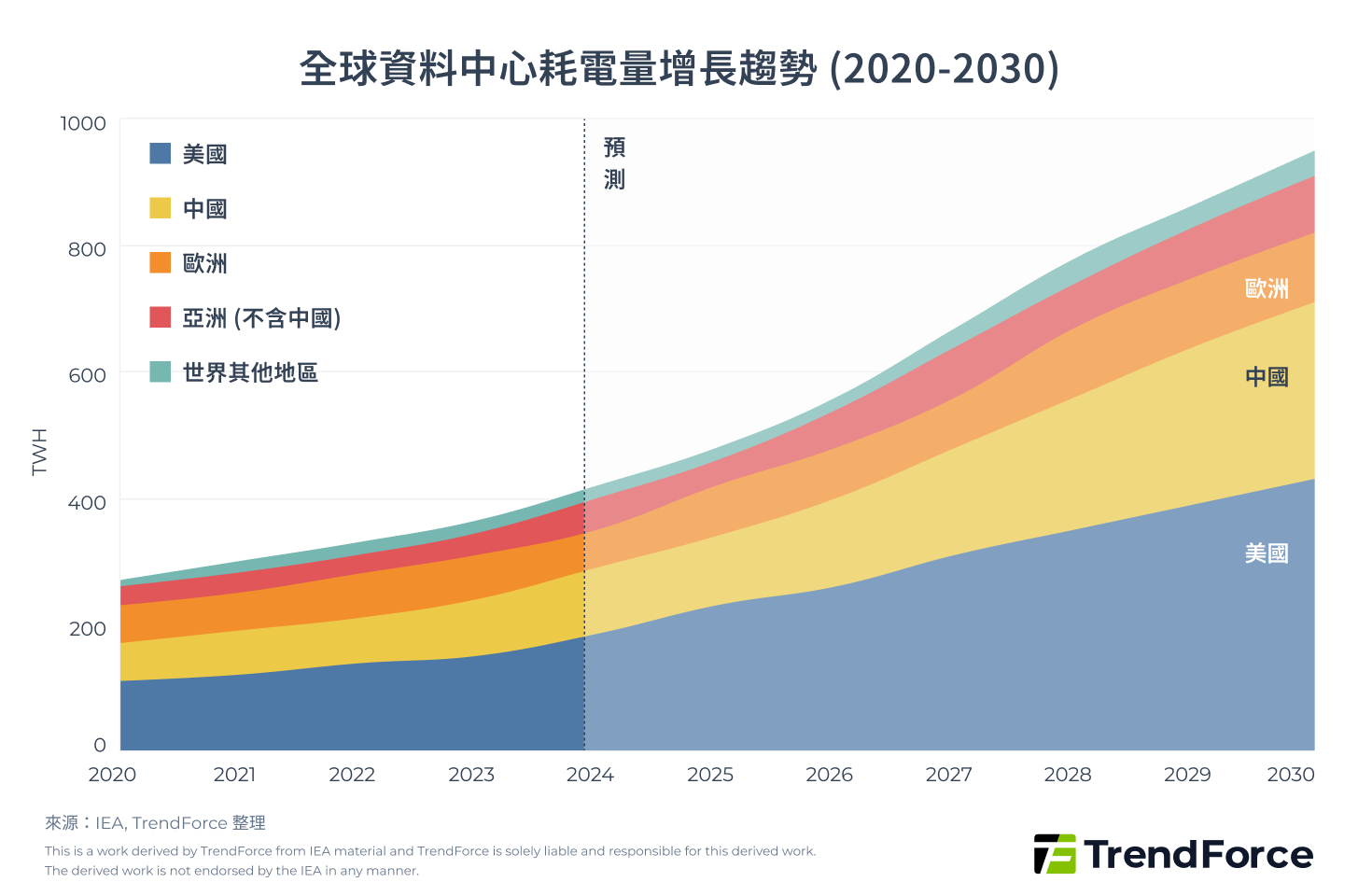

國際能源總署(IEA)預測全球資料中心用電量,於 2024 年達到 415TWh,預計在 2030 年將成長至約 945TWh,這表示六年內,電力消耗將出現驚人的翻倍狀況;美國能源部也評估資料中心耗電占比,將從 2023 年的 4.4% 提升至 2028 年的 6.7–12%。美國、歐洲和中國為代表的 AI 運算高度集中的主要經濟體,將持續劇烈推升全球用電曲線。

2026年展望:GW級資料中心元年與AI算力軍備競賽

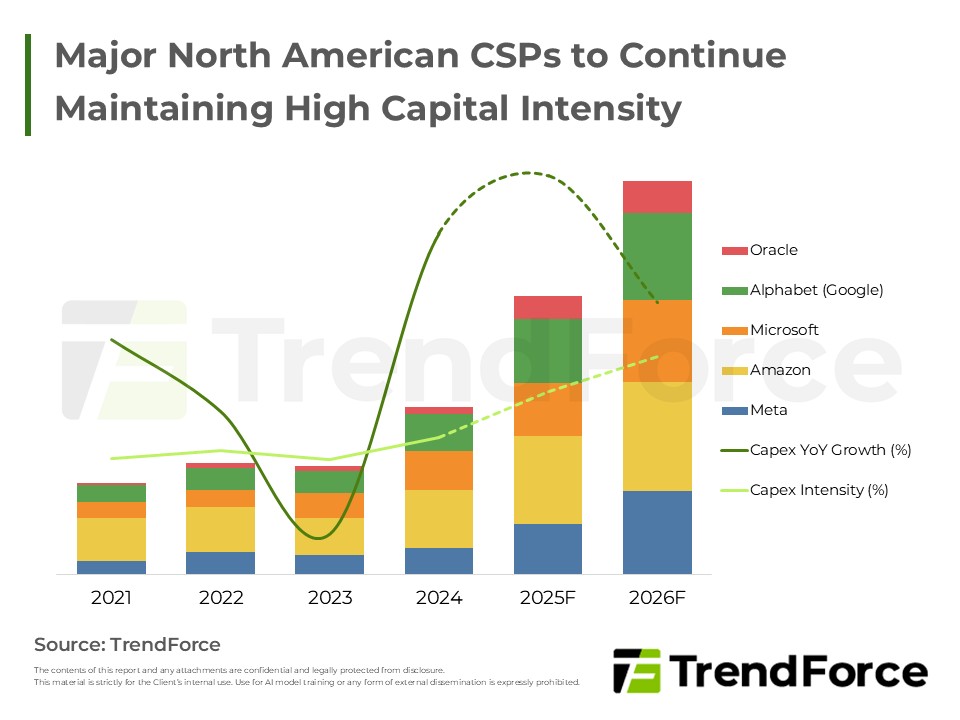

2026 為何被北美 CSP 視為 GW 級資料中心的關鍵轉折點?在 AI 投資全面超前部署下,OpenAI 透過 Stargate 跨入基礎設施建設,雲端產業結構正悄然改寫。

了解市場趨勢資料中心電力負載與運營挑戰

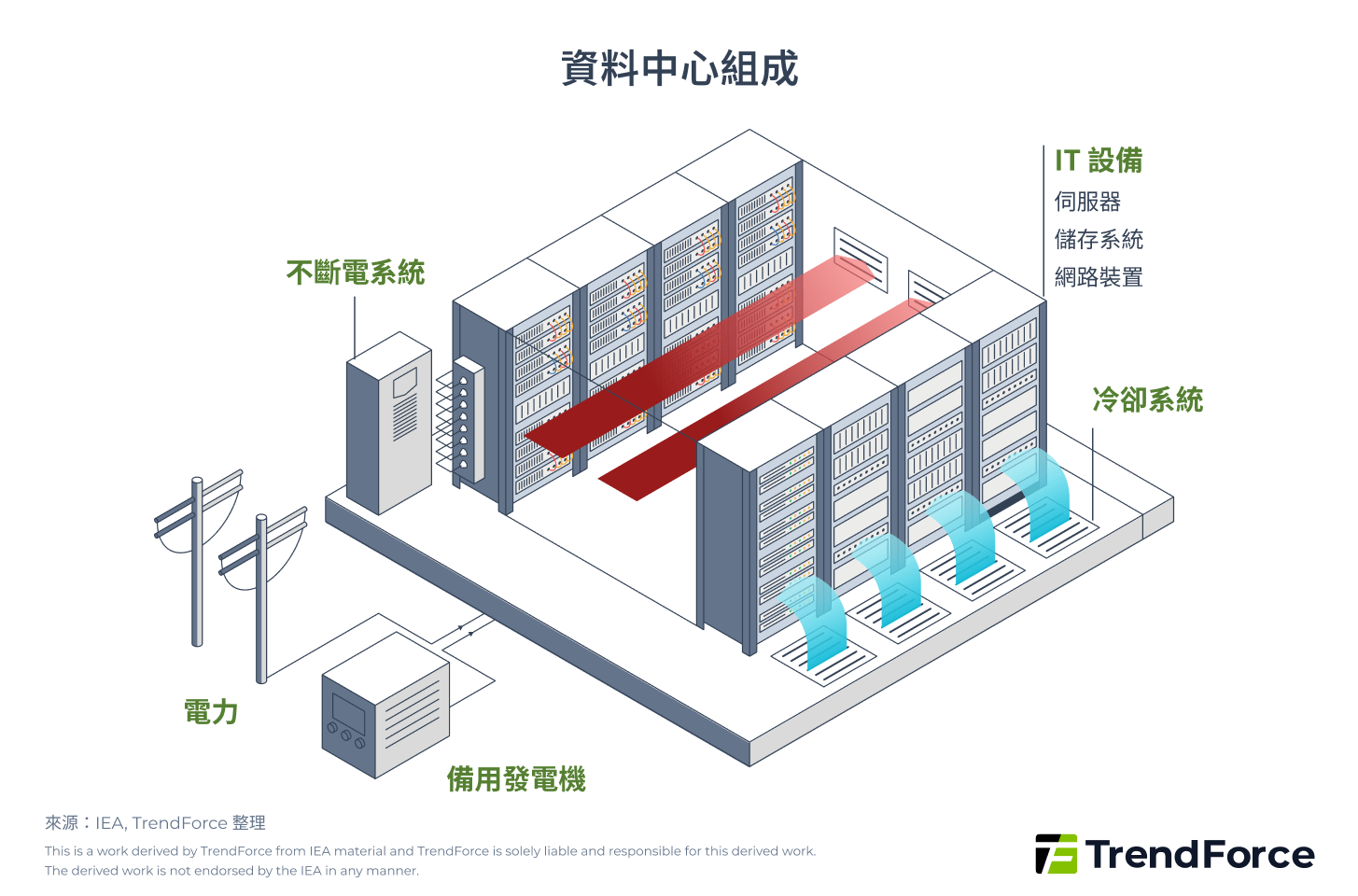

首先,現行資料中心主要電力消耗來自 IT 設備(伺服器、儲存系統、網路裝置)以及支援基礎設施(冷卻系統、不斷電系統 UPS、電力轉換、照明等)。

隨著 AI 模型運算需求密度飆升,直接推升 AI 伺服器的電力需求,這主要源於伺服器內建高功耗的 AI 加速器(包含 GPU、TPU、ASIC、FPGA 等運算晶片),使得每機架功耗從傳統約 5-10kW 躍升至 30-100kW 以上,帶動資料中心在電力與冷卻系統負荷同步增長。

以 NVIDIA 預計於 2027 年下半年推出的 Rubin Ultra NVL576 單晶片為例,其 TDP(熱設計功耗) 已達約 3.6kW,使單機櫃功率高達 600kW 級別,較過去 10-30kW 的水平增長數十倍。

面對電力需求激增,資料中心電力系統在面對 AI 工作負載的高負載波動性時,往往出現 UPS 備援與配電架構容量不足或響應延遲,限制資料中心能源效率並推高電力成本。伴隨著 AI 巨頭不斷投入基礎設施研發升級,新一代 AI 加速器功耗持續攀升,傳統供電架構的負荷壓力將進一步加劇。

表:資料中心電力需求分配與風險分析

| IT 設備 &基礎設施 | 電力需求占比約 | 主要風險與瓶頸 |

|---|---|---|

| 伺服器 | 60% | AI 伺服器單機架功耗超越傳統配電設計負荷,易造成線路過載與跳電風險 |

| 儲存系統 | 5% | 高頻存取導致 CPU 待機耗電增加,延長資料處理時間,間接推升整體系統功耗 |

| 網路設備 | 5% | 網路設備規格不足造成資料傳輸延遲,迫使伺服器長時間高負載運行 |

| 冷卻系統 | 20% | 傳統氣冷設計無法應對高密度熱源,大幅降低能源效率 |

| 其它基礎設施 | 10% | UPS/BBU 系統若未同步升級,將面臨轉換效率下降,無法有效應對短時間的高負載尖峰,導致保護力不足。 |

(電力需求占比來源:IEA)

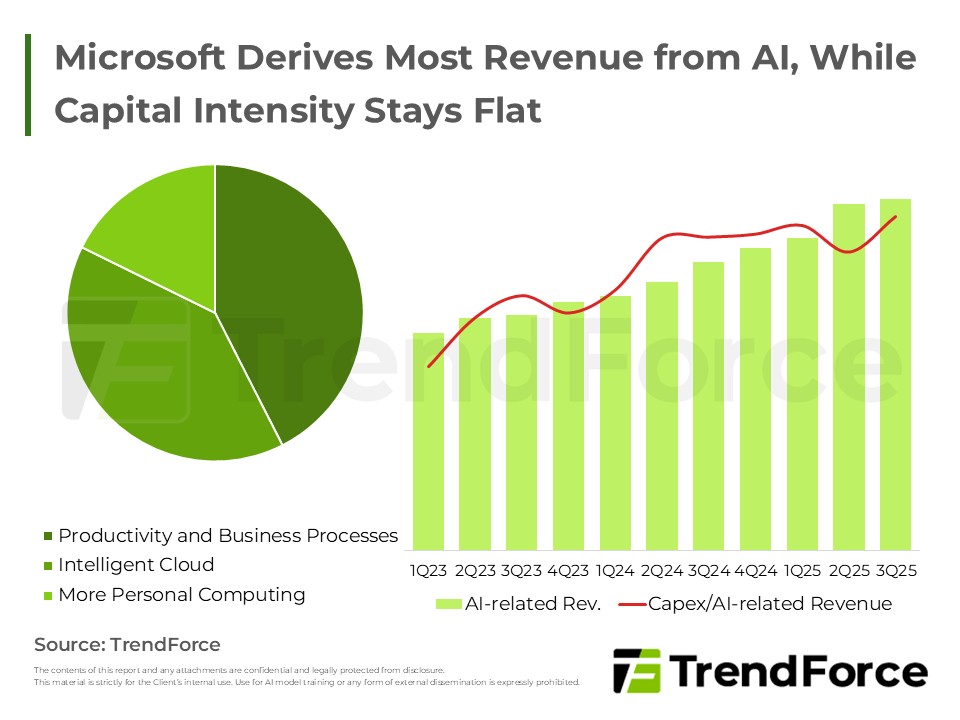

2026 趨勢展望:Microsoft和Meta的AI 資本支出與北美資料中心佈局

微軟與 Meta 加速 AI 基建布局。微軟透過租賃緩解產能瓶頸,穩定擴張雲端市占;Meta 則以快速部署與開源策略大幅加碼資本,誰能掌握 AI 主導權?

洞察 CSP 策略降低資料中心耗電的關鍵策略

PUE(電力使用效率)是衡量資料中心能源效率的國際通用指標,理想值應接近 1.0,代表更多電力被用於 IT 運算設備,而非消耗在冷卻或備援設施上。目前業界平均值約為 1.58。

$$ \mathrm{PUE} = \frac{\text{資料中心總用電量}}{\text{IT 設備總用電量}} $$

2024 年,各大 CSP(雲端服務供應商)已將 PUE 控制在約 1.1 的高水準,並持續優化以因應 AI 帶來的高工作負載。

- Google 的 PUE 報告指出,其資料中心 PUE 值為 1.09。

- Microsoft 的《環境永續報告》指出,其資料中心 PUE 值為 1.12。

- Amazon 的 AWS 報告指出,其資料中心 PUE 值為 1.15。

面對這些標竿數據,傳統資料中心必須正視其結構性挑戰。面對 AI 工作負載持續增長的趨勢,企業要達到雲端巨頭的 PUE 水準,已不能僅靠設備汰換,而需要從電力基礎設施到冷卻系統進行系統性優化。以下列出 4 項提升能效與降低耗電的策略。

1. 高效硬體設備與基礎設施,降低用電需求

傳統資料中心的基礎設計多以一般運算需求為導向,未針對 AI 工作負載的高功耗與高密度特性進行最佳化,因而出現能效比偏低、散熱壓力過大等限制。企業若要支撐生成式 AI 與高效能運算(HPC)的需求,可考慮導入以下新一代高效能硬體設備與創新基礎設施技術,從源頭降低電力消耗,同步提升整體運算效能與能源效率。

- 低功耗處理器與高頻寬記憶體的 AI 伺服器:

傳統 AI 伺服器面臨功耗密度過高的挑戰,單顆 GPU 功耗就高達 400-700W。

Intel、AMD、NVIDIA 等廠商透過先進製程與架構優化,開發高能效 CPU、GPU 與 AI 加速晶片,同步導入高頻寬記憶體模組(如 HBM 系列、DDR5、MRDIMM 技術)。AMD 於 2025 年 6月 發表新一代 AI 加速器Instinct MI350 系列 GPU,其能效與性能相較上一代,提供 4 倍 AI 運算能力,推論性能提升 35 倍。搭載此類高效 AI 加速器的新世代 AI 伺服器,能在相同運算任務下大幅降低每單位運算的耗電量。

- 高功率機櫃(HPR):

傳統 19 吋單櫃功率僅 5kW 到10kW 等級,無法滿足現今 AI 與 HPC 快速發展的需求。

各大 CSP(Meta、Google、Microsoft等)已大規模採用於開放運算計畫(OCP)推出的 ORv3-HPR V3 機櫃,其將 GPU 伺服器總功率密度推升至 300kW,能因應 AI 模型訓練、超算、高密度推理等運算場景。

此外,2025 年,Meta 在 OCP EMEA Summit 高峰會 上公布 ORv3-HPR V4 機櫃架構 規劃與展望,其首次採用了 ±400V(等效 800V)高壓直流方案,將整櫃負載更高水準推向 800kW,將能為未來大規模 AI 運算提供更充足的資料中心電力需求支援。

- 液冷與浸沒式冷卻技術:

傳統氣冷系統在面對高密度 AI 伺服器時效率低落,冷卻系統耗電佔資料中心電力需求 20-25%,如今 全球雲端資料中心迅速採用液冷作為冷卻標準。

而 Microsoft 2025 年 4 月於《Nature》期刊發表冷卻技術研究,冷卻板與雙相浸沒式冷卻技術分別可降低 15% 和 21% 溫室氣體排放,減少 20% 能源需求與 52% 水資源消耗。Supermicro 的液冷解決方案 可降低資料中心電力成本達 40%,有效改善 PUE 值表現。

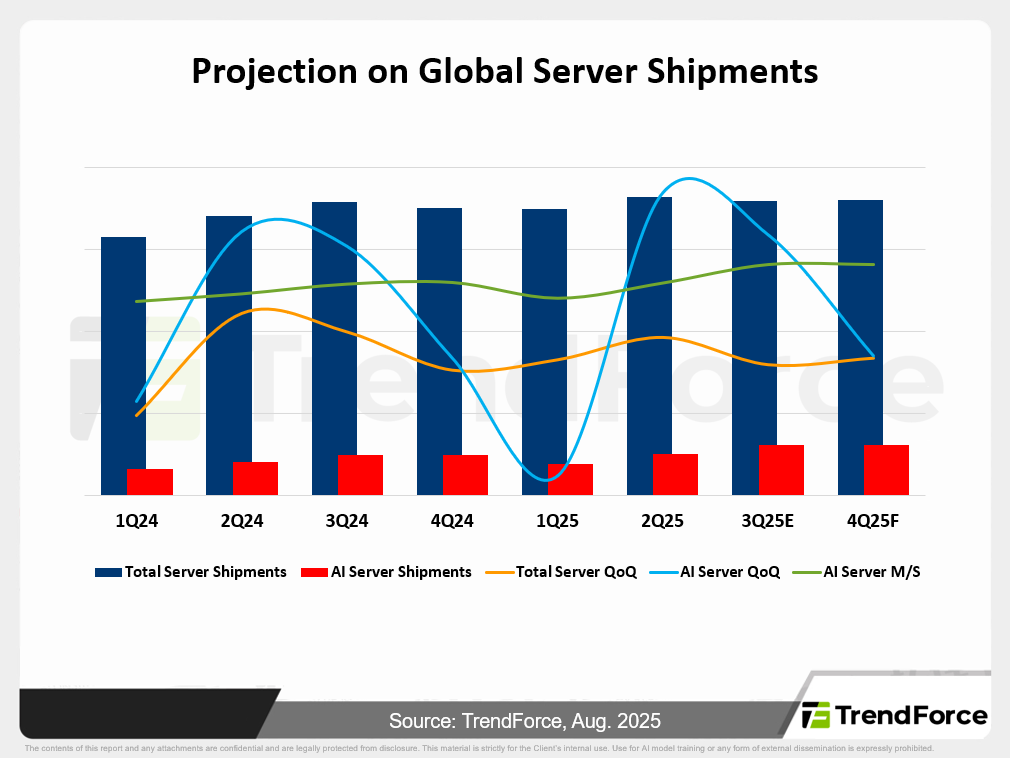

2025 下半年 & 2026 全球 AI 伺服器市場與供應鏈展望

生成式 AI 熱潮推動 AI 伺服器需求爆發,雲端服務商領航市場,出貨量持續超越通用伺服器,成為整體伺服器市場新焦點。 了解趨勢

2. 供電架構革新,減少電力傳輸與轉換損耗

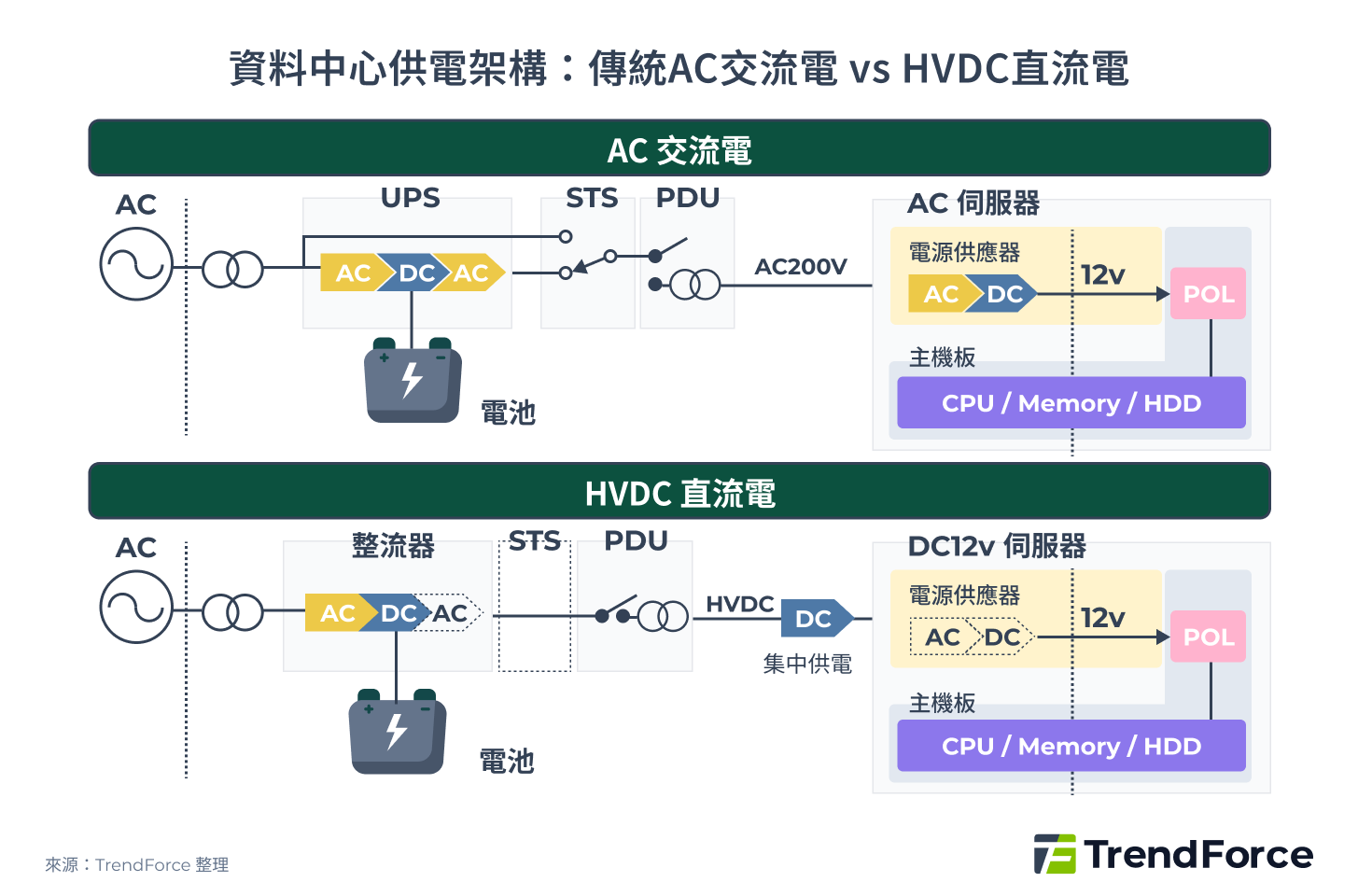

Vertiv 預測 2024 至 2029 年以後,AI 機櫃密度將從 50kW 暴增至 1MW。傳統資料中心多是 AC 供電架構搭配集中式 UPS(不斷電系統),未來將難以支撐供電,將面臨功率不足、多重 AC↔DC 電力轉換造成能耗偏高,以及 CSP 對新供電標準的要求。

HVDC(高壓直流)是一種透過高壓直流電直接送至機櫃,省去多重電力轉換的供電架構。台達電估計傳統 UPS 效率約 88%,使用 HVDC 全鏈路可達約 92%,雖僅 4% 效率差距,但對大型營運商每年可節省約 360 萬美元電費。

下圖顯示傳統 AC 供電架構與 HVDC 供電架構的電力轉換路徑差異:

- 傳統 AC 供電架構: AC 輸入 → UPS(AC→DC→AC轉換)→ STS 靜態轉換開關 → PDU 配電盤 → 伺服器內建電源(AC 200V→DC 12V)

- HVDC 供電架構: AC 輸入 → RECTIFIER 整流器(AC→DC)→ PDU 配電盤 → 伺服器(HVDC直接供電,僅需DC→DC轉換至12V)

HVDC 架構的核心優勢在於減少電力轉換環節,省去大型 UPS 設備與 STS 靜態轉換開關,系統架構更為簡潔。CSP 巨頭與 NVIDIA 兩大陣營雖技術路線不同,但都瞄準同一目標—讓 HVDC 從概念驗證躍升為新產業供電標配。

過渡期解決方案:模組化 UPS(不斷電系統)

在全面導入 HVDC 前,多數資料中心仍沿用標準 AC + UPS,而模組化 UPS 提供實用的過渡方案。其基於現有 AC 供電架構,具備高實用性與低實施成本,也是技術人員熟悉的架構。

其分散式設計可依負載動態擴容,解決傳統整體式 UPS 缺乏彈性問題。Rehlko 2023 年的文章指出,模組化 UPS 標準運行模式可達 96% 線上能源效率;Schneider Electric也提及其機櫃空間可節省約 50% 占地面積。部分模組故障時仍能維持運作,大幅降低停機風險。

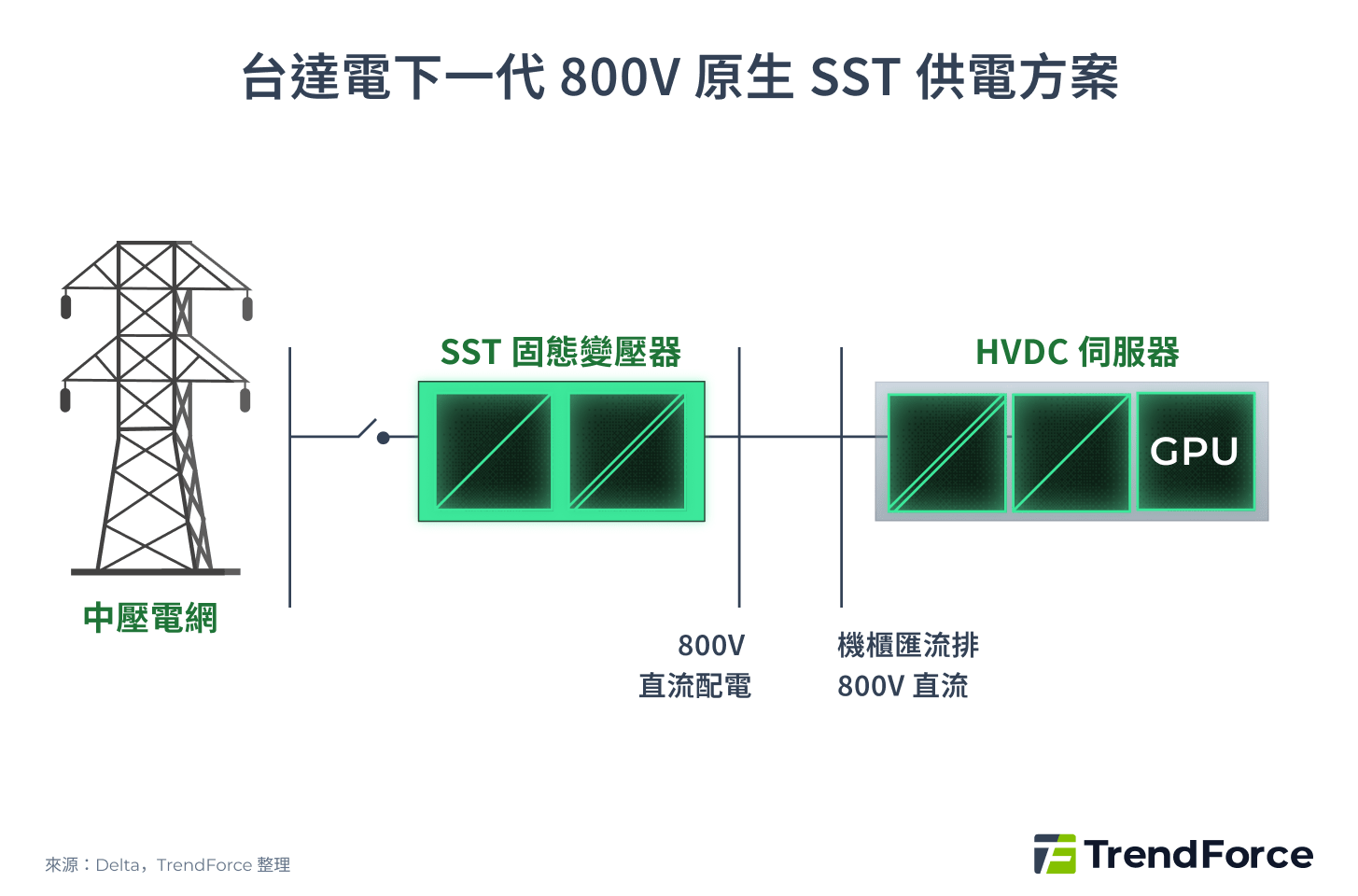

供電架構發展再精簡

傳統資料中心供電需經歷工頻變壓器、UPS、配電櫃等多層轉換,路徑冗長且損耗累積。

固態變壓器(SST)正成為新一代方案,市電無須再經過多層轉換,而是直接送入 SST 模組整流並輸出 HVDC,大幅減去 2-3 個換流損耗,讓供電系統更緊湊。

台達電已提出 SST 結合 HVDC 架構發展路徑圖,能源效率可達約 92%,SST 有望成為未來資料中心供電演進的關鍵技術。

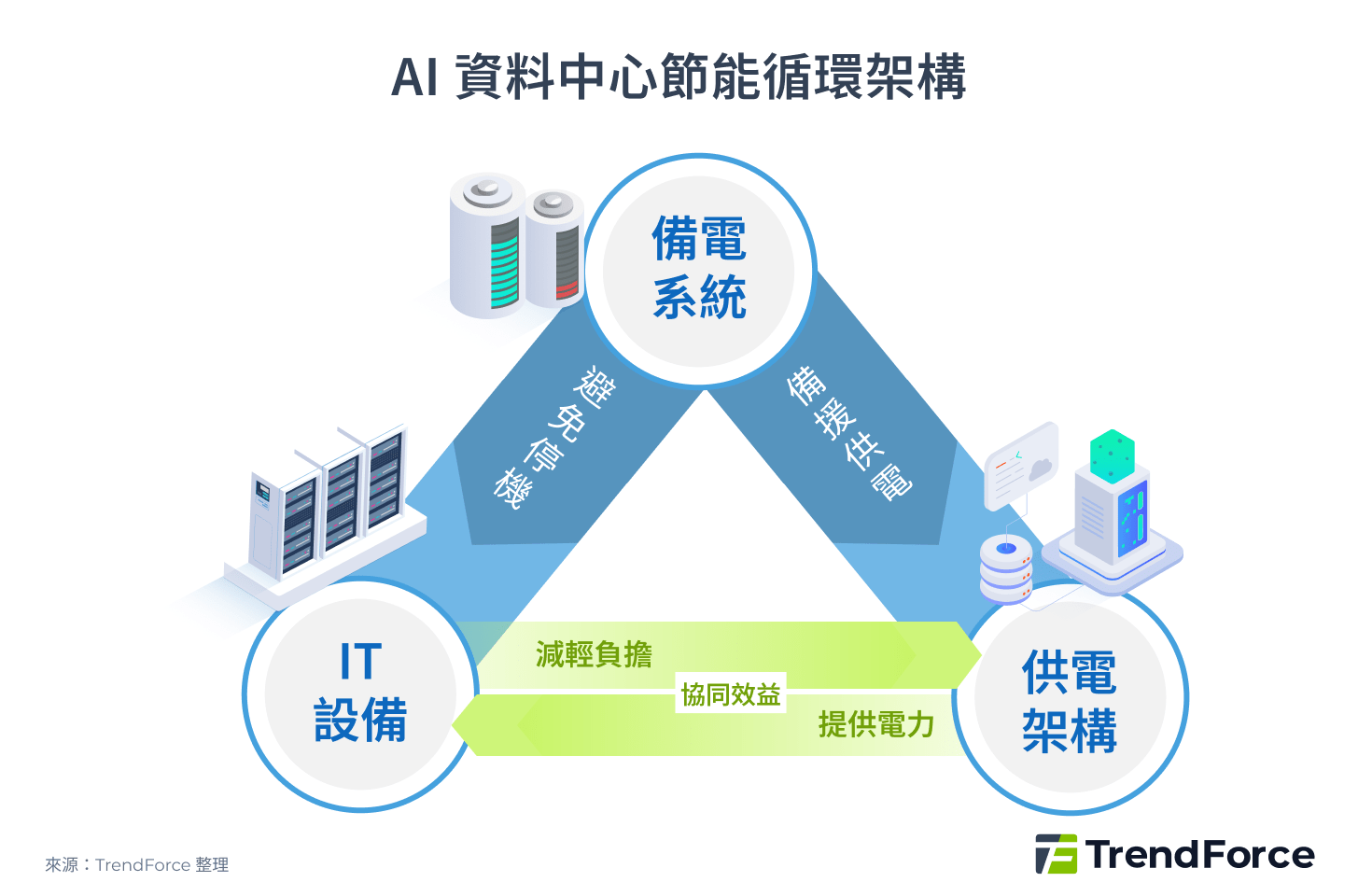

3. 分散式備電系統,全面降低停機風險

傳統資料中心多採集中式 UPS 為整個機房提供備援,但若 UPS 發生故障或轉換延遲,整個區域伺服器將同時停機。同時,UPS 容量受限,難以應對 AI 瞬時功耗激增,容易造成電力閃斷。根據 Uptime Institute 2024 年《全球資料中心調查報告》,23% 的停機事件源自電力問題,54% 的營運商表示最近一次重大停機損失超過 10 萬美元,其中 20% 的事件甚至超過百萬美元。

為解決此問題,BBU(電池備援單元)是直接放在伺服器或機櫃端的「分散式備援電系統」,因靠近伺服器,反應速度遠快於集中式 UPS,且故障僅影響單一機櫃,具備更高彈性與可靠性。

表:UPS vs BBU 備電系統

| 比較項目 | UPS 不斷電系統 | BBU 電池備援模組 |

|---|---|---|

| 功率路徑 | AC → DC → AC → IT 負載 | 與 HVDC 或 48V DC 匯流排並聯,平時充電、斷電時放電 |

| 部署位置與範圍 | 設於配電間,保護整排或整廳負載 | 部署於伺服器機櫃內或側邊電源櫃,保護單一機櫃 |

| 電池配置 | 鉛酸電池 | 鋰電池 |

| 使用壽命 | 約 3-5 年 | 約 5-10 年 |

| 故障影響 | 單點故障可能導致大範圍停機 | 局部影響,其他機櫃可繼續運作 |

| 反應速度 | 受限於轉換延遲 | 靠近伺服器,瞬時反應更快 |

另一項關鍵配置是「超級電容」,能在 AI 訓練或推理時「緩衝」突發功耗尖峰,避免供電不穩並減輕 BBU 負擔。超級電容負責即時響應,BBU 提供持續備援,兩者搭配能讓資料中心供電系統更穩定、壽命更長。

提升資料中心能效:硬體、供電架構與智慧備援

資料中心能源優化需多層面並進:升級硬體設備降低耗電、革新供電架構提升傳輸效率、部署分散式備電系統確保營運穩定。這些解決方案互為支撐,從節省需求到提升效率,再到強化可靠性,全方位提升能源效率與 PUE。

然而,新技術導入也會面臨挑戰,例如 HVDC 與分散式備電系統需與現有 AC 架構整合,初期投資成本高、系統整合複雜、技術人員培訓需求增加,並需管控新舊系統並行的風險。企業應採取階段性導入策略,平衡投資回報與營運風險,並建立跨部門協作,確保升級順利。

AI 巨頭與電力設備大廠推動供電系統革新

供電架構變革不僅依靠技術突破,更透過產業聯盟,塑造著未來的供電標準。隨著 AI 與 HPC 用電負載快速攀升,傳統機櫃架構已難以支撐,開放運算計畫(Open Compute Project, OCP) 扮演關鍵角色。OCP 自 2011 年由 Meta、Intel 等廠商發起,旨在透過開源硬體模式重新定義資料中心基礎設施。

經過 OCP 社群多年迭代,2024 提出的 ORv3-HPR 系列作為在 AI 運算供電上的策略性過渡,為未來的 Mt. Diablo HVDC 奠定了模組化基礎。代表整體產業都在尋求高效、高密度供電的解決方案。

AI 巨頭供電策略分歧

在這場供電系統革新中,以 NVIDIA 為代表的 AI 巨頭和 Meta、Microsoft、Google 等大型雲端服務商組成的 OCP 社群,形成了兩種主要的 HVDC 路線:

- OCP ±400V 雙極方案:

透過 OCP Mt. Diablo 計畫推動 ±400V HVDC 混合架構,主幹沿用 480 VAC,僅在獨立電源櫃轉換為 ±400 VDC 後跨櫃供應伺服器,使 IT 機架功率可從 100kW 擴展到 1MW。雖效率不如 800V 全直流,但兼具相對成熟與彈性的技術,未來將逐步過渡到完整直流架構。

- NVIDIA 800V 單極直流架構:

為滿足 MW 級 AI 機櫃需求,採用 800V 單極 DC 架構。交流電在變電室入口透過 SST 轉為 800 VDC,直接供應 800V 原生伺服器,使相同導線下的電力傳輸量提升 85%。展望 2028 年,SST 將逐步全面導入,形成完整的一條龍 HVDC 架構,實現最高效率與精簡化管理。

資料中心邁向 HVDC 時代的供應鏈新格局

AI 算力需求飆升推動資料中心邁向 HVDC(高壓直流)的供電架構時代,這項轉變正形塑出一個嶄新的相關供應鏈格局。供電供應鏈可分為三個主要層級:

- 資料中心電力基礎設施:由 Schneider Electric、Eaton、Vertiv 等傳統電力與配電大廠主導,其掌握高壓開關、匯流匣與固態變壓器(SST)等中高壓設備的關鍵技術,提供 HVDC 系統的安全落地與能源品質管理。

- 電源系統零組件:由台達電、光寶科、Flex 等代表廠商主導,涵蓋從白區到 IT 櫃體的直流配電與能量轉換,核心技術包括 Power Rack(電源機櫃)、BBU(電池備援單元)、超級電容與匯流排,提供高效能電力傳輸與穩定供電保障。

- 功率半導體解決方案:由 Infineon、Renesas、ROHM、Onsemi、TI 等廠商引領,利用碳化矽(SiC)與氮化鎵(GaN)等第三代半導體材料,打造高效能、高密度的千伏級切換元件,是決定 HVDC 架構性能極限的關鍵。

展望未來,HVDC 趨勢將促使整個產業鏈朝向更高度的垂直整合,模糊傳統供應鏈界線。台灣廠商已形成一套由本土企業主導的完整產業集群,從電源模組、備援電力、散熱管理到機櫃整合,能在最短迭代週期內交付 MW 級 HVDC 解決方案,奠定台灣在全球 HVDC 生態系統的關鍵樞紐地位,為全球資料中心營運商提供更具時效性的競爭優勢。